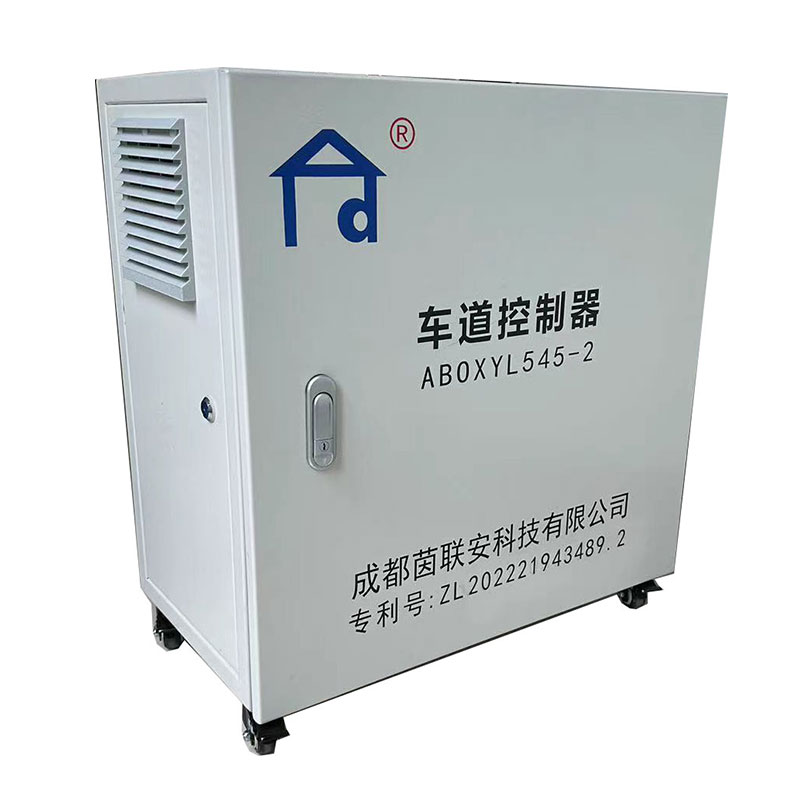

Завод по производству компьютеров для полос движения

Когда слышишь про заводы, выпускающие компьютеры для полос движения, многие представляют себе конвейеры с готовыми устройствами. Но в реальности это всегда начинается с тестового полигона, где инженеры месяцами проверяют, как платы держат вибрацию от грузовиков. Мы в Чэндуское технологическое ООО Иньлянань через это прошли — и знаем, что ключевая ошибка новичков в том, чтобы считать такие системы просто ?усиленными ПК?. На деле это гибрид промышленного контроллера и сетевого шлюза, где даже разъёмы должны выдерживать перепады от -40°C до +70°C. Помню, как в 2012 году мы поставили первую партию в Казань, и выяснилось, что стандартные блоки питания выходят из строя при длительной работе под снегом. Пришлось переделывать всю схему охлаждения — и это типичная история для отрасли.

Почему ?железо? для полос — это не серверные стойки

Если брать готовые промышленные компьютеры, они часто избыточны по защите от пыли, но не учитывают специфику дорожных датчиков. Например, в системах интеллектуальных транспортных систем данные с камер и радаров идут асинхронно, и процессор должен обрабатывать их без буферных задержек. Мы в Иньлянань сначала пробовали адаптировать платформы для АСУ ТП, но столкнулись с тем, что они ?не видят? резкие изменения освещённости в туннелях. Пришлось разрабатывать собственные модули с динамической калибровкой — и это оказалось дешевле, чем покупать лицензии у немецких производителей.

Кстати, про температурные режимы: в Новосибирске на развязке у аэропорта наши компьютеры работают в кожухах с пассивным охлаждением, но внутри стоит дополнительный контур для отвода тепла от процессора. Это не описано в учебниках — пришлось придумать самим, когда заметили, что при -30°C вентиляторы обмерзают, а без них чипы перегреваются от нагрузки. Такие нюансы решаются только полевыми испытаниями, и ни один каталог оборудования этого не покажет.

Ещё один момент — совместимость с устаревшими системами. В том же Казани при интеграции с светофорами 2000-х годов оказалось, что их протоколы передачи данных не поддерживаются современными сетевыми картами. Мы добавили в компьютеры слоты для устаревших интерфейсов RS-485, но при этом сохранили совместимость с IoT-датчиками. Это типичный компромисс, без которого проект бы просто не запустился.

Как искусственный интеллект меняет подход к проектированию

С 2018 года мы в Чэндуское технологическое ООО Иньлянань начали внедрять системы управления с использованием искусственного интеллекта не только для анализа трафика, но и для самодиагностики оборудования. Например, компьютеры теперь предсказывают износ SSD-накопителей по паттернам записи данных с камер — это снизило количество внезапных сбоев на 40%. Но изначально алгоритмы перегружали процессоры, и мы месяц экспериментировали с балансировкой нагрузки между CPU и GPU.

При этом ИИ — не панацея. В Сочи мы пытались использовать нейросети для прогнозирования потока машин на круговых перекрёстках, но выяснилось, что локальные компьютеры не справляются с обучением моделей в реальном времени. Пришлось перенести часть вычислений в облако, а на местах оставить только инференс. Это добавило задержек в передаче данных — и такие тонкости редко обсуждаются на конференциях.

Интересный кейс — адаптация под российские ГОСТы. Европейские аналоги часто не учитывают требования к электромагнитной совместимости в промзонах, где рядом с дорогами работают радары. Мы добавили экранирование на уровне плат, но при этом пришлось пересмотреть разводку питания, чтобы избежать помех от силовых кабелей. Это стоило нам трёх месяцев тестов, зато теперь оборудование стабильно работает даже в промзонах Урала.

Интеграция слаботочных систем: что не пишут в техзаданиях

Системная интеграция слаботочных систем — это всегда про скрытые работы. Например, при подключении компьютеров к датчикам веса на МКАД оказалось, что кабельные трассы проходят рядом с линиями электропередач. Помехи вызывали ложные срабатывания, и мы потратили две недели на поиск причины — в итоге помогла установка ферритовых фильтров непосредственно на клеммах. Такие детали редко прописывают в контрактах, но они критичны для запуска.

Ещё проблема — согласование с энергетиками. В том же проекте пришлось доказывать, что наши компьютеры не создадут перегрузку в сети 220В. Разработали схему с поэтапным включением устройств, но это потребовало изменения логики ПО — пришлось переписать часть кода для контроллеров питания. Без опыта таких работ можно застрять на стадии пусконаладки на месяцы.

Кстати, про ПО: мы используем собственные прошивки для управления питанием, потому что стандартные Linux-дистрибутивы не оптимизированы для длительной работы без перезагрузки. В Шереметьево наши компьютеры работают по 2-3 года без остановки, но для этого пришлось отключить ненужные сервисы и настроить мониторинг состояния памяти. Это та самая ?кухня?, которую не покажут в рекламных буклетах.

Мониторинг и тестирование: почему лабораторные условия не работают

Когда мы только начинали внедрять технологии мониторинга и тестирования, думали, что стендовых испытаний достаточно. Но в 2015 году в Хабаровске компьютеры, проверенные в идеальных условиях, начали глючить при первом же дожде — оказалось, конденсат скапливался в разъёмах Ethernet. С тех пор мы тестируем всё в климатических камерах с циклами ?жара-холод-влажность?, но даже это не заменяет полевых тестов.

Например, для проекта в Крыму мы специально возили оборудование на побережье, чтобы проверить устойчивость к солёному воздуху. Выяснилось, что стандартные радиаторы корродируют за 4-6 месяцев — пришлось переходить на анодированный алюминий. Такие открытия делают только на месте, а не в отчётах поставщиков.

Сейчас мы используем систему предиктивной аналитики, которая собирает данные с наших компьютеров по всей России. Это помогает предсказывать сбои — скажем, в Ростове-на-Дону мы заранее заменили блоки питания, когда алгоритм показал рост ошибок в журналах. Но чтобы это работало, пришлось научить местных техников правильно интерпретировать данные — и это отдельная задача, про которую часто забывают.

Эволюция подходов: от железа к экосистеме

Если в 2007 году, когда создавалось Чэндуское технологическое ООО Иньлянань, мы думали в первую очередь о надёжности ?железа?, то сейчас говорим о создании экосистемы. Наши компьютеры для полос движения — это не просто устройства, а узлы в сети, которые обмениваются данными со светофорами, камерами и даже мобильными приложениями водителей. Например, в проекте для М11 мы связали их с системой оповещения о дорожных работах — и это потребовало пересмотра архитектуры процессоров.

При этом мы не гонимся за сверхновыми технологиями. В том же проекте пробовали использовать квантовые датчики для подсчёта машин, но оказалось, что они слишком чувствительны к вибрациям от грузовиков. Вернулись к проверенным радарам, но добавили к ним алгоритмы для фильтрации помех — и это сработало надёжнее. Опыт подсказывает, что в инфраструктурных проектах стабильность важнее инноваций.

Сейчас мы видим, как меняется спрос: если раньше заказчики просили ?компьютер для полосы?, то теперь хотят ?решение для управления потоком?. И это правильно — потому что изолированные устройства уже не справляются с нагрузками мегаполисов. На сайте https://www.yinland.ru мы как раз акцентируем это, показывая, как наши системы работают в комплексе. Но за каждым таким кейсом — годы проб и ошибок, про которые не пишут в пресс-релизах.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продуктыСвязанный поиск

Связанный поиск- Дешевые основных покупателей SD считыватель карт

- Поставщики интеллектуальных терминалов Ai в Китае

- Заводы по производству промышленных компьютерных стоек в Китае

- картридер для ноутбука

- Дешевые промышленные сенсорные компьютеры основных покупателей

- Дешевые вход/выход контроллер платы фабрик

- Производители промышленных компьютеров Intel

- Заводы OEM Intel промышленных компьютеров

- Поставщики дешевых устройств для записи и считывания информации

- Поставщики OEM IO Cards